De Rasha Abdul Rahim, Advocate/Adviser on Arms Control, Security Trade & Human Rights at Amnesty International,

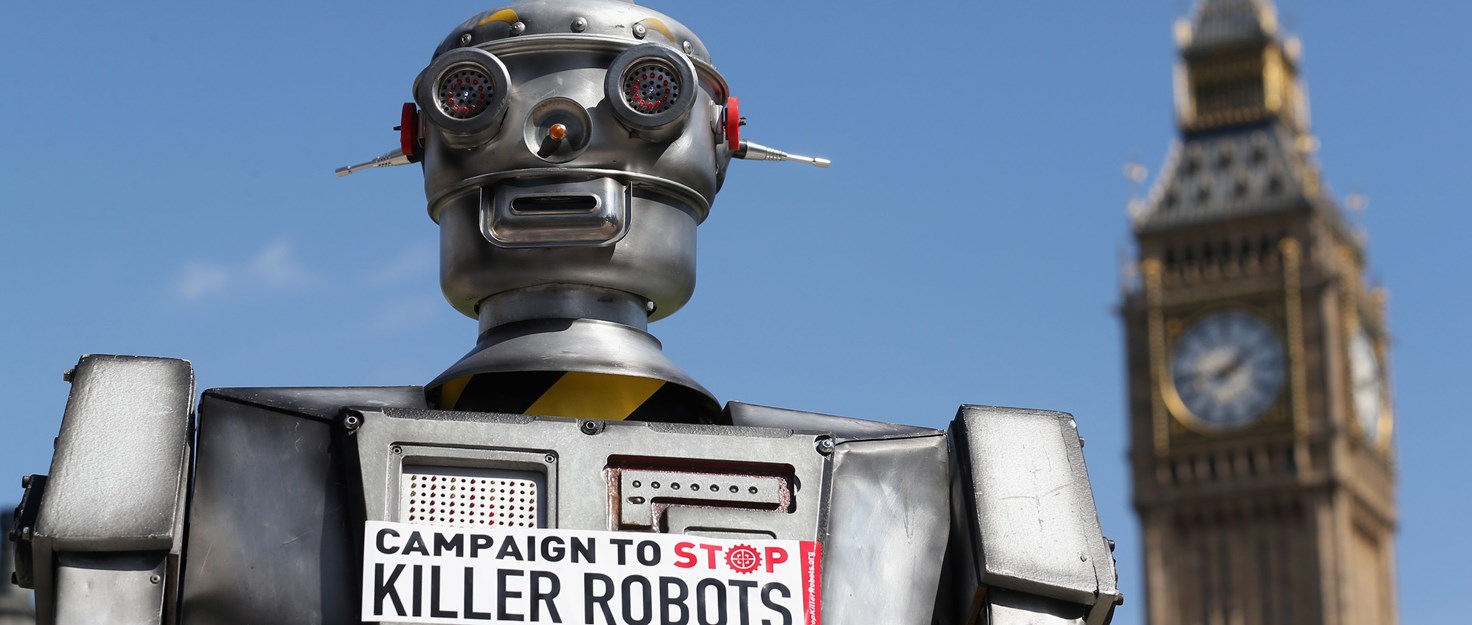

Hoy se celebra, en Ginebra, una reunión de gobiernos para hablar sobre los “robots asesinos”. Amnistía Internacional pide que se abra un proceso formal de negociación para prohibir a escala mundial los “robots asesinos” y las armas robóticas menos letales, tanto en el campo de batalla como en operaciones policiales. He aquí 10 razones por las que la prohibición es indispensable.

1. No falta mucho para que los “robots asesinos” dejen de ser ciencia ficción

Los robots asesinos son armas que, una vez activadas, pueden seleccionar blancos humanos, y atacarlos, matarlos y herirlos sin necesidad de que nadie las controle. Estas armas, que antes eran objetos de ciencia ficción distópica, se conocen como “sistemas de armas autónomos”, y pronto serán realidad.

De hecho, existen ya numerosos modelos básicos. Por ejemplo, el dron ShadowHawk, de la empresa estadounidense Vanguard Defense, al que es posible acoplar un lanzagranadas, una escopeta con designador láser u otras armas menos letales, como las Taser o un lanzador de perdigones. En 2011, la oficina del sheriff del condado de Montgomery (Texas), adquirió un ShadowHawk no armado con una subvención del Departamento de Seguridad Nacional. Este año, en agosto, Dakota del Norte se convirtió en el primer estado de Estados Unidos en legalizar el uso de drones teledirigidos para lanzar descargas eléctricas de alto voltaje incapacitantes.

2. Los gobiernos que eluden la rendición de cuentas las utilizarán expresamente con fines represores

Algunos gobiernos arguyen que los “robots asesinos” pueden reducir los peligros que entraña el despliegue de soldados en el campo de batalla, o de la fuerza policial en delicadas operaciones de mantenimiento del orden. Sin embargo, eso significa que, con estas armas, los gobiernos podrían participar más fácilmente en nuevos conflictos armados y utilizar la fuerza, por ejemplo, en el desempeño de tareas policiales durante manifestaciones. Si bien es cierto que esto podría redundar en la seguridad de los soldados y de la policía, esta simplificación podría favorecer la multiplicación de conflictos y la intensificación del uso de la fuerza y, por tanto, incrementar el peligro para la población civil.

Quienes defienden los “robots asesinos” sostienen que su ausencia de emociones eliminaría características humanas negativas, como el miedo, la venganza, la ira y los errores humanos. Sin embargo, las emociones humanas son a veces un importante factor de moderación a la hora de matar o herir a la población civil, y sería fácil programar a robots para que atacaran de forma indiscriminada o arbitraria a personas, incluso a escala masiva. Los “robots asesinos” serían incapaces de negarse a desobedecer órdenes, actitud que a veces puede salvar vidas. Por ejemplo, durante las protestas masivas de enero de 2011 en Egipto, el ejército se negó a disparar contra los manifestantes, demostrando así un sentimiento de compasión humana y de respeto al Estado de derecho.

3. No cumplirían el derecho internacional de los derechos humanos ni las normas policiales internacionales

Las normas policiales internacionales prohíben el uso de armas de fuego salvo en defensa propia o de otras personas, en caso de peligro inminente de muerte o lesiones graves, y exigen limitar el uso de la fuerza al mínimo necesario. Resulta muy difícil imaginarse a una máquina juzgando, como un humano, si existe un peligro directo y real de que una persona mate a otra y, a continuación, utilizando la mínima fuerza necesaria para detener el ataque. Sin embargo, ese juicio es de la máxima importancia a la hora de decidir si un agente si debe o no utilizar un arma. Las Normas de la ONU exigen a la policía, en la mayoría de las ocasiones, utilizar medios no violentos, como la persuasión, la negociación y la mitigación de tensiones antes de recurrir a la fuerza.

Una actuación policial efectiva conlleva mucho más que el uso de la fuerza: requiere también el uso de aptitudes exclusivamente humanas, como la empatía y la neutralización, y la capacidad de evaluar situaciones a menudo dinámicas e impredecibles, y responder a ellas Estas aptitudes no pueden reducirse a meros algoritmos, pues requieren evaluar situaciones que están en constante evolución, y determinar cuál es la mejor manera de proteger el derecho a la vida y a la integridad física, algo que las máquinas, sencillamente, no pueden hacer. La decisión de un funcionario encargado de hacer cumplir la ley sobre el uso de la mínima fuerza necesaria en una situación concreta implica un juicio humano sobre la naturaleza de la amenaza, y un control considerable del arma. En otras palabras, no se pueden dejar en manos de máquinas decisiones de vida o muertes.

4. No cumplirían las leyes de la guerra

Los principios de distinción, proporcionalidad y precaución son los tres pilares sobre los que se asientan el derecho humanitario internacional y las leyes de la guerra. Las fuerzas armadas deben distinguir entre combatientes y no combatientes; las bajas civiles y los daños a edificios civiles no deben ser excesivos en comparación con la ventaja militar prevista; y todas las partes deben tomar precauciones para proteger a la población civil.

Como es evidente, todo esto requiere un juicio humano. Los robots no tienen la capacidad de analizar la intención de una acción humana, ni de tomar decisiones difíciles sobre la proporcionalidad o la necesidad de un ataque. Y no digamos nada de la necesidad de compasión y empatía por la población civil atrapada en una guerra.

5. Habría un enorme vacío en lo que se refiere a la rendición de cuentas por su uso

Si un robot violara la ley, ¿quién respondería ante la justicia? Se podrían pedir responsabilidades a quienes lo hubieran programado, fabricado y puesto en marcha, y a los agentes de mando y líderes políticos. Sin embargo, sería imposible que ninguno de estos agentes previera cómo podría reaccionar un “robot asesino” en una circunstancia dada, con lo que surgiría un vacío en la rendición de cuentas.

De hecho, en la actualidad escasean ya las investigaciones sobre homicidios ilegítimos cometidos por drones, y son menos frecuentes aún las medidas de rendición de cuentas en esos casos. En su informe sobre los ataques de drones estadounidenses en Pakistán, Amnistía Internacional puso al descubierto el secretismo que rodeaba el uso de drones para matar por parte del gobierno estadounidense, y la negativa de éste a explicar la base jurídica internacional que le permitía lanzar distintos ataques, lo que hizo temer que los bombardeos de zonas tribales paquistaníes hubieran violado derechos humanos.

Ya ha sido bastante difícil pedir responsabilidades en ataques con drones, así que, si añadimos una capa de separación más en las decisiones sobre selección y aniquilación de objetivos, como ocurriría en el caso de los “robots asesinos”, lo más probable sería que presenciáramos un aumento en el número de lesiones y homicidios ilegítimos, tanto en el campo de batalla como en operaciones policiales.

6. El desarrollo de “robots asesinos” dará lugar a otra carrera armamentística

China, Israel, Rusia, Corea del Sur, Reino Unido y Estados Unidos son algunos de los muchos países que están desarrollando en la actualidad sistemas para dotar de mayor autonomía a las máquinas de combate. En varios países, hay ya empresas que han desarrollado armas robóticas semiautónomas, que pueden disparar gas lacrimógeno, balas de goma y dardos paralizantes en las operaciones policiales.

La historia del desarrollo armamentístico indica que sería sólo cuestión de tiempo que esto diera lugar a otra carrera armamentística de alta tecnología, en la que los Estados tratarían de desarrollar y adquirir estos sistemas, favoreciendo así su proliferación. Estas armas acabarían en los arsenales de gobiernos sin escrúpulos y, en último extremo, en manos de agentes no estatales, como grupos armados de oposición y bandas criminales.

7. Permitir que las máquinas maten o empleen la fuerza es un atentado contra la dignidad humana

Permitir que un robot tenga poder de decisión sobre la vida y la muerte supone cruzar una línea moral básica. Los robots carecen de emociones, empatía y compasión, y su uso violaría los derechos humanos a la vida y a la dignidad. El uso de máquinas para matar seres humanos es el mayor atentado posible a la dignidad humana.

8. Si alguna se desplegaran “robots asesinos”, sería casi imposible detenerlos

Tal como ha puesto de manifiesto la propagación incontrolada de los drones, una vez que se empieza a utilizar un arma, es extremadamente complicado, por no decir imposible, regular o –incluso– reducir su uso.

El documento “The Drone Papers” que publicó recientemente The Intercept, transmite, de confirmarse, un panorama alarmante sobre un programa de drones letales estadounidenses. Según estos documentos, durante un periodo de cinco meses, el 90 por cierto de las personas que murieron en ataques con drones estadounidenses eran blancos no deseados, lo que pone de manifiesto la constante y dilatada falta de transparencia del gobierno estadounidense con respecto a su programa de drones.

Parece que ya es demasiado tarde para abolir el uso armamentístico de los drones, pero es preciso restringir radicalmente su uso para salvar vidas de civiles. Los “robots asesinos” multiplicarían con creces el peligro de homicidios ilegítimos. Por ello, es preciso prohibirlos, como medida preventiva. Si nos limitamos a adoptar una actitud pasiva de espera, estaríamos favoreciendo el crecimiento de las inversiones en el desarrollo de estos sistemas y su rápida proliferación.

9. Miles de personas expertas en robótica han pedido que se prohíban los “robots asesinos”

En julio de 2015, algunos de los principales investigadores sobre inteligencia artificial, científicos y profesionales de campos relacionados de todo el mundo firmaron una carta abierta en la que pedían la prohibición expresa de los “robots asesinos”.

Hasta la fecha, son 2.587 las personas que han firmado esta carta, entre ellas más de 14 presidentes y ex presidentes de organizaciones y asociaciones profesionales de inteligencia artificial y robótica. Entre las personas firmantes más destacadas figuran Demis Hassabis (director ejecutivo de Google DeepMind), Elon Musk (consejero delegado de Tesla) Steve Wozniak (cofundador de Apple), Jaan Tallin (cofundador de Skype) y el profesor Stephen Hawking.

Si miles de expertos científicos y jurídicos están tan preocupados por el desarrollo y el posible uso de los “robots asesinos” y están de acuerdo con la Campaña contra los Robots Asesinos, que pide su prohibición, ¿a qué esperan los gobiernos?

10. En los últimos dos años se ha hablado mucho, pero se ha hecho poco

Desde que se pusieron de manifiesto los problemas que entrañaban los “robots asesinos”, en abril de 2013, el único diálogo internacional serio que se ha celebrado al respecto ha sido la reunión informal de expertos, que se celebró durante dos semanas en Ginebra, en el marco de la conferencia en torno a la Convención sobre Ciertas Armas Convencionales de la ONU. Resulta absurdo que se haya dedicado tan poco tiempo a un peligro tan grave, y que se haya avanzado tan poco.

Para Amnistía Internacional y sus socios de la Campaña contra los Robots Asesinos, la única solución real es prohibir por completo el desarrollo, despliegue y uso de armas letales autónomas.

El mundo no puede esperar más para actuar ante una amenaza mundial tan grave. Es hora de tomarse en serio, de una vez por todas, la prohibición de los robots asesinos.